2023年の米国株市場で、AI銘柄の本番として急上昇を演じたのがエヌビディア(NVDA)です。同社の株価は年間を通して、143.15ドルから495.22と345%という記録的な上昇を記録しました。

同社は2024年以降、どのような成長が期待されるのでしょうか。

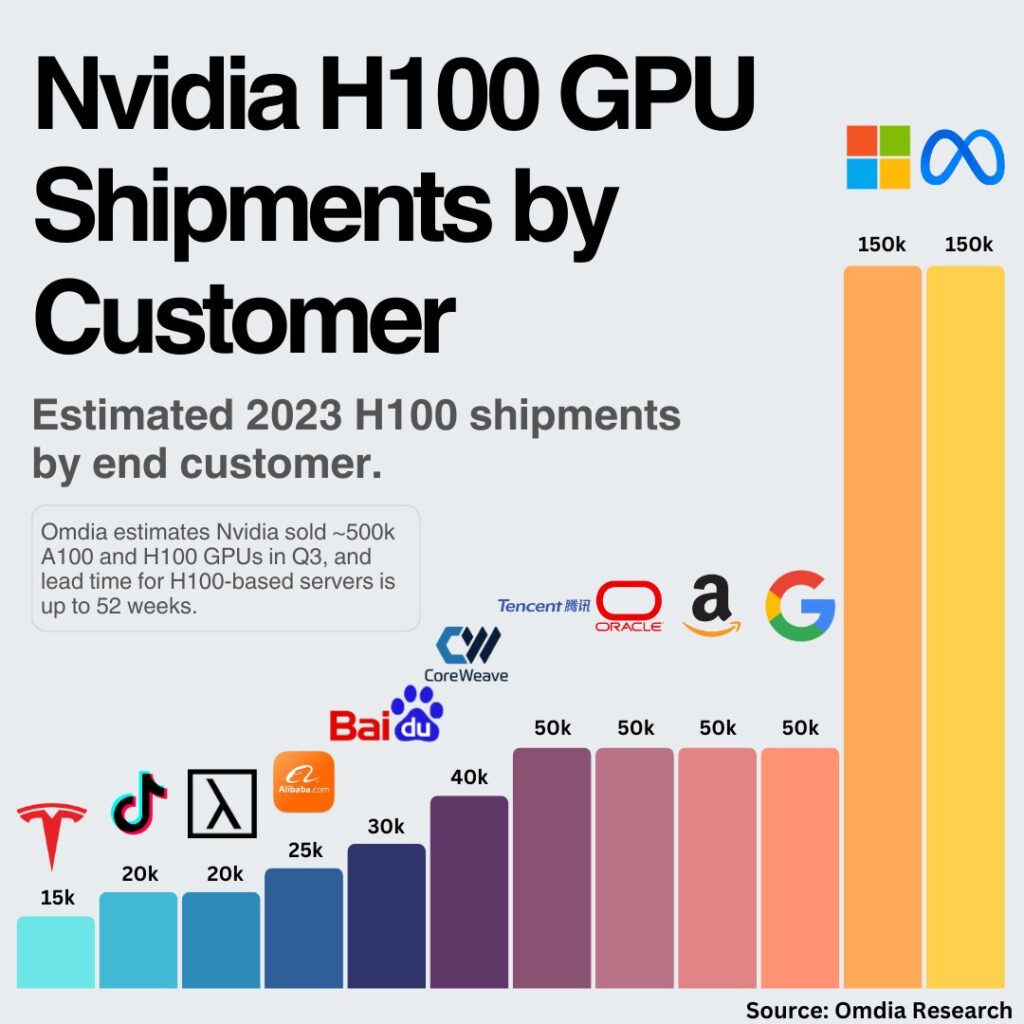

2023年に主に注目されたのは、AIを手掛けるビッグテックがこぞって導入した、NVIDIA H100 GPUを搭載したサーバーでした。エヌビディアのH100 Tensor コア GPUは、最新のTSMC 4Nプロセスを使用して構築された、世界で最も先進的なHopperベースのGPUです。H100は、80GBのGPUメモリ、第4世代のTensorコアを搭載し、3,026 teraFLOPSのFP8 Tensor コア性能を誇ります。H100は、大規模言語モデル(LLM)におけるパフォーマンスを前世代比30倍に高速化することで、AI開発競争に参戦する世界中のテック企業が導入に殺到しました。

2023年のデータセンター向けの次世代GPUは、2024年には、同社は「H200」と次世代機種の「B100」を投入する計画があると報じられています。

AI時代の莫大なデータセンター需要はどれだけのものなのか、同社の未来の半導体需要について、XのThe AI Invester氏が解説しています。

世界中に約8,000のデータセンターが点在し、それぞれがNVIDIAのGPUを大量に導入する可能性があります。NVIDIAの最新のGPUモデル、H100やGH200などに焦点を当て、これらのデータセンターが初期段階で各々16,000個のGPUを購入すると仮定すると、NVIDIAは驚異の1億2,800万個のGPUを販売することになります。

この壮大な数字は、NVIDIAが2023年に販売した約50万台のH100や、2024年に約200万台を売り上げたことと比較しても、その潜在的な市場規模の大きさを物語っています。実際、潜在的な初期需要は2024年の出荷量の64倍にもなるとされています。GPU一台あたり約30,000ドルの価格を考慮すると、今後数年間での総売上は約3兆8,400億ドルにも上ると予測されています。

さらに、NVIDIAのCEO、ジェンセン氏は、ジェンセン氏は、今後 4 年間で AI 用のデータセンターのアップグレードに 1 兆ドルが費やされると述べました。 3兆8,400億ドルという金額に達すると、これはAMDのCEO、リサ・スー氏が予測する年間4000億ドルの市場規模と一致し、この分野の巨大な成長潜在力を示しています。このような巨大な市場規模は、投資家にとって間違いなく注目すべき話題であり、NVIDIAの株式に投資することの潜在的な価値を浮き彫りにしています。

監修者のコメント:Xの投稿の前段にあたる解説は、人間が指示をして執筆しています。

当記事は投資の推奨ではありません。投資は、ご自身の判断で行ってください。